Réchauffement anthropique, Partie 1 : La fin de la récréation

Shaun Lovejoy

Professeur au Département de Physique, Université McGill, Montréal, Qué.

Introduction

La science et la connaissance avancent par l’opposition systématique des idées, des modèles et des paradigmes, puis la confrontation des théories avec des données. La science est donc remplie de controverses. Bien que la plupart des théories en sciences naturelles n’aient d’intérêt que pour les spécialistes concernés, il arrive parfois qu’elles menacent les conceptions dominantes du monde ainsi que notre place dans ce dernier. Le plus illustre exemple est possiblement l’émergence de l’héliocentrisme, qui en 1633 mena au bannissement des travaux de Copernic en 1633 et a valu à Galilée de se faire montrer les instruments de torture. Bien que l’héliocentrisme ait été profondément en conflit avec la doctrine de l’Église, c’était bien plus qu’une simple question d’idéologie. À l’époque, les auteurs et poètes qualifièrent l’héliocentrisme de « ridicule » (Jean Bodin, 1592) ou encore comme porteur d’un profond désespoir (John Donne, 1611, « Le Soleil est Perdu… »). L’Église a simplement réaffirmé et officialisé le « gros bon sens », c’est-à-dire le géocentrisme, et a du même coup fait de l’héliocentrisme une doctrine hérétique (Sherwood, 2011).

Les siècles se sont enchaînés et nous sommes aujourd’hui témoins d’une confrontation similaire, en l’occurrence à l’idée reçue selon laquelle le climat est une contrainte externe devant laquelle l’humanité impuissante ne peut espérer que s’adapter. La réalité est toute autre: l’action humaine modifie le climat. Plutôt que d’être une partie bienveillante et nourricière de Mère Nature, le climat se révèle comme altérable et potentiellement malveillant. L’industrie des combustibles fossiles et autres intérêts complices n’ont seulement qu’à semer le doute et doucement leurs lobbys entretiennent la réconfortante illusion préscientifique. Malheureusement, le parallèle avec l’héliocentrisme s’arrête ici, car les conséquences d’une mauvaise conception du réchauffement anthropique sont bien plus qu’idéologiques. Si nous échouons à le ralentir et à mitiger son effet, les conséquences pourraient être terribles pour le futur de l’humanité. Je ferai ici le résumé de progrès récents en ce qui à trait à notre compréhension du climat, ainsi que l’apport anthropique au changement climatique en cours, et tiendrai la thèse que d’un point de vue purement intellectuel et scientifique, nous sommes (finalement) arrivés à la fin du débat climatique. Le débat n’est plus rationnel. Les climato-sceptiques ne sont que des négationnistes climatiques. Je discuterai ensuite des conséquences du changement climatique, et comment agir, en particulier pour les humanistes.

Qu’est-ce que le climat ?

L’adage dit que « le climat est ce à quoi on s’attend, la météo est ce qu’on reçoit », signifiant que le climat est la météo typique ou moyenne. Il se trouve que c’est un point de vue théorique, détaché de la réalité de l’atmosphère (Lovejoy, 2013). Une analyse empirique démontre que pour des périodes allant jusqu’à dix jours, les fluctuations de température, de vélocité éolienne ou autres quantités reliées à l’atmosphère, tendent à augmenter avec l’échelle temporelle, c’est-à-dire, par exemple, qu’en moyenne on doit s’attendre à ce que la température de la semaine prochaine soit plus éloignée d’aujourd’hui que celle de demain. Par contre, cette relation s’inverse pour des périodes allant de 10 jours jusqu’à 30 ans. Bref, à cette échelle, plutôt que d’augmenter avec le temps, les fluctuations tendent à s’annuler entre elles. Des moyennes sur des périodes de plus en plus longues semblent donc tendre à converger vers une valeur stable. C’est le régime qui satisfait l’idée que « le climat est ce à quoi on s’attend ». Malgré tout, passé trente ans, pour l’ère post-industrielle, et passé cent ans, pour la période pré-industrielle, cette moyenne recommence à errer, les fluctuations augmentent encore avec l’échelle temporelle. Par exemple, les normales climatiques, définies comme une moyenne sur trente ans, auront tendance à fluctuer de manière croissante sur des périodes allant jusqu’à des dizaines de milliers d’années, périodes correspondantes, par exemple, aux âges glaciaires. Il y a donc trois différents régimes, pas que deux. J’ai d’ailleurs proposé que le régime intermédiaire, un genre de météo plus « lente », soit dénommé « macro météo » et que le terme « climat » soit réservé aux plus grandes périodes, caractérisées par des variations instables. Une façon équivalente de comprendre ces deux comportements types est de dire que pour le régime macro météo, caractérisé par la stabilité, les boucles de rétroaction négatives dominent alors que pour les périodes plus grandes, les boucles de rétroaction positives dominent, puisque ces dernières périodes sont caractérisées par l’instabilité. Si l’on applique la même approche à l’éon phanérozoïque, les derniers 542 millions d’années, qui vit l’avènement du règne animal, on trouve que pour des échelles temporelles d’environ 1 million d’années et plus, appelons ce régime « méga climat » les fluctuations de température tendent encore à augmenter avec l’échelle [Lovejoy, 2014e]. Cela signifie que sur cette période, les boucles de rétroaction positive l’emportent sur les négatives, un comportement contraire à l’homéostasie terrestre telle que conçue par Lovelock avec l’hypothèse de la « terre vivante » ou l’hypothèse Gaïa. Nous y reviendrons.

La distinction entre la météo, la macro météo et le climat est utile pour comprendre le réchauffement anthropique. Aux temps préindustriels, ce n’est qu’aux échelles supérieures à environ un siècle que les processus naturels, à action lente, réussissent à surpasser les processus macro météorologiques stabilisants, alors que pour la période post-industrielle, définie comme les années après 1880, les effets anthropiques dépassent les variations climatiques naturelles et commencent ainsi à dominer la macro météo pour des périodes supérieures à seulement trois décennies. C’est important puisque ça veut dire que la variation depuis 1880, environ un siècle, est due en grande partie à la variabilité anthropique plutôt que naturelle. On peut donc séparer de manière assez précise les variations anthropiques des naturelles.

Une brève histoire du réchauffement anthropique

Pourquoi la Terre se réchauffe-t-elle ? En 1896, essayant de comprendre les causes des âges glaciaires, le chimiste suédois Svante Arrhenius estima que si la concentration atmosphérique de dioxyde de carbone doublait, la température globale augmenterait de 5-6 degrés Celsius. Puis en 1938, Guy Stewart Callander révisa cette estimation à 2 degrés Celsius. Ces deux estimations sont en fait assez près des estimations modernes. D’un point de vue scientifique, l’idée est simple. Le dioxyde de carbone est un gaz à effet de serre (GES) laissant la lumière visible du soleil passer, mais retenant une partie de la chaleur ré-émise par la Terre, augmentant donc la température globale. La réalité est plus complexe, des boucles de rétro-action entre le dioxyde de carbone, la vapeur d’eau et les nuages amenant un grand degré d’incertitude que nous discuterons plus bas.

La prochaine grande étape dans l’étude du réchauffement anthropique fut le développement par Charles Keeling d’une nouvelle technique pour estimer la concentration de dioxyde de carbone qui permit, en 1957, de commencer à mesurer sur une base régulière la concentration à deux endroits différents, l’Antarctique et Mauna Loa, deux sites choisis pour leur isolement, réduisant ainsi l’effet de perturbations locales dues à l’agriculture ou à l’industrie. Ces mesures démontrèrent sans l’ombre d’un doute que le taux moyen annuel de dioxyde de carbone dans l’atmosphère était en croissance continuelle. On a pu aussi déterminer ainsi qu’environ la moitié des émissions reste atmosphérique alors que l’autre moitié se dissout dans les océans. Finalement, dans les années 70, le développement d’immenses modèles sur des super-ordinateurs, les Modèles de circulation générale ou GCM de l’anglais « Global Circulation Model », nous permirent d’estimer qu’un doublage du dioxyde de carbone atmosphérique mènerait à une augmentation de la température globale d’environ 1.5 à 4.5 degrés Celsius (Académie Nationale des Sciences des États-Unis, 1979). C’est l’augmentation à laquelle on doit s’attendre si tout d’un coup on doublait la concentration de dioxyde de carbone et attendions d’atteindre un nouveau point d’équilibre. En effet, et cela souligne les limites liées à cette approche, malgré les progrès majeurs tant dans les algorithmes que dans la puissance de calcul des ordinateurs, le même résultat a été présenté dans le plus récent rapport du Groupe Intergouvernemental d’Experts sur l’Évolution du Climat, le GIEC (GIEC, cinquième rapport du GIEC, RE5, 2013).

Scepticisme légitime et illégitime

Lorsque confrontée à un nouvel ensemble de faits ou à une nouvelle théorie, l’attitude scientifique correcte en est une de scepticisme désintéressé. L’histoire du réchauffement anthropique montre que cette théorie a dû surmonter plusieurs critiques [Weart, 2008]. Si on décide d’ignorer les effets de rétroaction liés à la vapeur d’eau et aux nuages, le réchauffement anthropique devient simple à établir. La mécanique elle-même de l’effet de serre n’a jamais été mise en doute. La difficulté principale, qui nécessita le développement des modèles numériques, était d’estimer les boucles de rétroaction. Même aujourd’hui elles sont toujours difficiles à quantifier ce qui explique que l’intervalle de 1.5-4.5 degrés Celsius, lié au doublement du dioxyde de carbone, reste assez large.

Même dans les années 60, alors que les mesures prises par Keeling étaient bien connues, la résistance principale à la théorie du réchauffement dû au dioxyde de carbone était, comme mentionné dans l’introduction, plutôt idéologique. On disait que le réchauffement était très faible et la possibilité d’une contribution humaine au changement climatique qui serait dominante répugnait. Finalement, les associations météorologiques officielles de l’époque refusèrent de l’endosser. Il faut dire que l’époque n’était pas un terreau fertile pour Keeling étant donné que dans l’après-guerre on assistait à un refroidissement naturel (1944-1976).

Après le calcul du premier Modèle de circulation globale (Manabe et Wetherald, 1975), les critiques passèrent au manque de réalisme des modèles ainsi qu’aux piètres qualités et quantités de données. En effet, ce ne fut pas avant les années 80 que les preuves du réchauffement devinrent vraiment convaincantes. Pour ce qui est des modèles, la critique est particulièrement facile étant donné qu’un modèle parfait n’existe tout simplement pas. Aujourd’hui les modèles de circulation globale sont immensément complexes et assemblés par de grandes équipes. On peut raisonnablement croire qu’un seul individu comprenant chaque partie du modèle n’existe pas non plus. Bien qu’un modèle ne puisse décrire la réalité de manière infaillible, il peut répondre à des questions spécifiques comme l’existence de points de bascule liés à des boucles de rétroaction par exemple. Malgré tout, les modélisateurs sont bien conscients de ces limites et ainsi les critiques légitimes des modèles sont partie intégrante du développement routinier des modèles de circulation générale, ce qui implique une large gamme de tests et comparaisons avec des données réelles. De mon point de vue, extérieur à la communauté modélisatrice étant issue du domaine de la physique non linéaire, des années d’études m’ont mené à la conclusion que les prédictions de modèles analysés sur de larges gammes d’échelles temporelles et spatiales ont en effet des types de variabilité assez semblables aux données, donc réalistes.

Même si l’on ignore les modèles, la température croissante nécessitait une explication. Les sceptiques ont donc commencé une longue bataille pour remettre en question les données, les extrémistes doutant de la réalité même du réchauffement. Par exemple, dans les années 90 l’effet « d’îlots de chaleur », dans lequel les températures mesurer sont augmentées de façon nonrepresentatif de leur région par le développement de zones urbaines entourant des zones auparavant non développées par l’homme, fut utilisé pour déclarer les estimés de température globale biaisés. Par ailleurs, les mesures de la température atmosphérique, et non de surface, ont d’abord échoué à corroborer la tendance au réchauffement déjà mesuré par les stations de surface. Les protagonistes principaux de cette saga furent les scientifiques évangélistes chrétiens J. Christy et R. Spencer qui collaborèrent à l’analyse. Les deux furent francs en ce qui a trait à leur religion avec une publication récente justifiant leur scepticisme basé sur les Écritures: « La Terre et ses écosystèmes, créés par la conception intelligente et le pouvoir infini de Dieu est maintenue par Sa fidèle providence, sont robustes, élastiques, s’autorégulent et s’autocorrigent ». Au cours des quinze années qui suivirent leur publication initiale, pas moins de quatre erreurs subtiles furent identifiées dans leur interprétation des mesures par satellite [Mann, 2012]. Dès 2005, il devint clair que contrairement aux prétentions initiales, les satellites supportaient en fait la tendance au réchauffement de surface observé. Un an plus tard, vint le son du glas pour le scepticisme légitime. Michael Shermer, éditeur du magazine Skeptical Inquirer (littéralement: « L’enquêteur sceptique »), changea de position disant qu’à la lumière des nouveaux développements survenus en science climatique, s’opposer à l’idée du réchauffement anthropique sur les bases du scepticisme serait antiscientifique.

Le problème est que quand il y a des intérêts en jeu, les règles habituelles du discours intellectuel et du scepticisme scientifique ne s’appliquent plus. C’est particulièrement vrai aux États-Unis où des groupes de réflexion de droite tels que l’Institut Marshall et le Science and Environment Policy Project furent généreusement financés par l’industrie des hydrocarbures. Par exemple en 1998, Exxon-Mobile leur alloua 20 millions de dollars dans le but de répandre le doute à propos du réchauffement anthropique, lancer une campagne de publicité afin d’affirmer que le réchauffement n’était ni réel ou dommageable et effectuer des actions lobbyistes auprès du congrès États-Unien. En 2007, le American Enterprise Institute offrit 10 000$ ainsi que le remboursement de dépenses pour effectuer des tournées de conférences critiquant le quatrième rapport du GIEC qui venait d’être publié. En 2012, l’Institut Heartland paya des individus pour intervenir sur Internet pour dénigrer l’idée d’un réchauffement anthropique et de plus, paya aussi des scientifiques pour écrire des rapports exprimant des points de vue sceptiques. L’institut commença aussi une campagne afin qu’on introduise des éléments de climato-scepticisme dans les curriculums scolaires. Dans une étude récente Brulle (2014) établit que pas moins de 91 différentes organisations, incluant des groupes de réflexion, des groupes de défense et des associations professionnelles, avec un financement combiné de plus de 900 millions de dollars par année, forment collectivement un « contre-mouvement sur la question des changements climatiques ».

Les tactiques climato-sceptiques sont difficilement compatibles avec le principe du débat désintéressé. En effet, ces techniques ont souvent été exactement les mêmes que celles utilisées par les compagnies tabatières pour nier les effets délétères liés à la consommation de cigarettes. Certains individus ayant fait carrière en tant que « sceptiques » avec l’industrie tabatière se sont simplement recyclés en « climatosceptiques » ! Une tactique sceptique est de décrédibiliser des publications réputées en y juxtaposant des citations provenant d’une multitude de sources prises hors contexte. De cette façon, on amplifie de simples désaccords entre scientifiques et on exagère la signification de n’importe quelle erreur, peu importe son importance réelle, pour ainsi vraiment dénigrer la science.

Finalement, la sociologie et la politique du climatoscepticisme sont « impressionnantes ». Aux États-Unis, au moins, sous l’égide du fondamentalisme religieux, il y a eu une convergence des organisations créationnistes et climatosceptiques se servant des mêmes médias, tels Fox News, et des mêmes porte-paroles, tels Glenn Beck et Rush Limbaugh. Un excellent survol, écrit par un participant actif, est le livre : « Le Bâton de Hockey et les Guerres Climatiques : Missives en Provenance du Front » (« The Hockey Stick and the Climate Wars: Dispatches from the Front Lines ») [Mann, 2012].

Une nouvelle et simple démonstration du réchauffement climatique sans modèles de circulation générale

Aucune théorie scientifique de la nature peut être prouvée d’une manière mathématique et rigoureuse. Il y aura toujours de la place pour un « doute raisonnable ». Dans le cas du réchauffement anthropique, les démonstrations ont comporté plus que souvent d’immenses modèles dont les tenants et aboutissements étaient souvent difficiles à comprendre même pour les spécialistes. Puisqu’aucun modèle n’est parfait, cela a réconforté les sceptiques pour qui l’argument fondamental est l’inadéquation des modèles, permettant d’affirmer que le réchauffement est purement naturel. J’aimerais présenter ici de nouveaux travaux qui démolissent cette position suffisante. J’ai lancé l’idée initiale aux Sceptiques du Québec qui en 2012 demandèrent: « Si le réchauffement est si évident, pourquoi est-ce qu’un superordinateur est nécessaire pour le démontrer ? » (La présentation répondant à la question peut être consultée sur mon site web: http://www.physics.mcgill.ca/~gang/Lovejoy. htm voir le résumé (en Français, [Dubé, 2013]). Comme nous verrons, la démonstration sans modèle nous donne un résultat plus puissant. Nous pouvons rejeter l’hypothèse sceptique affirmant que le réchauffement n’est rien de plus qu’une gigantesque fluctuation naturelle centenaire. Notons au passage une asymétrie fondamentale de la méthode scientifique. Il est beaucoup plus facile de réfuter une théorie que d’en prouver une afin que le résultat résolve et apaise effectivement le débat scientifique ou intellectuel [Lovejoy, 2014d], [Lovejoy, 2014c], [Lovejoy, 2014b].

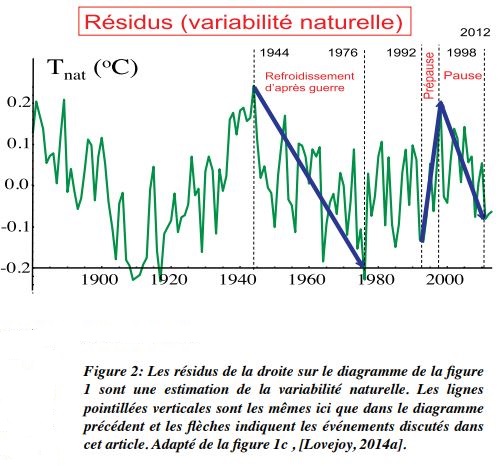

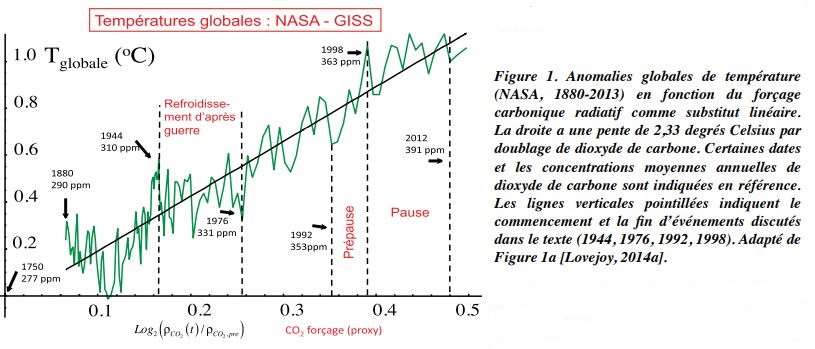

J’ai expliqué plus haut que le dioxyde de carbone est responsable d’un forçage climatique positif, phénomène altérant la balance énergétique. Il y a cependant une variété d’autres forçages anthropiques ayant un impact significatif. Les plus importants sont les autres gaz à effet de serre (notamment le méthane), mais aussi les aérosols, c’est-dire de fines particules en suspens souvent issues de la pollution qui tendent à « brunir » l’atmosphère, de ce fait refroidissant la Terre en réfléchissant de la radiation solaire vers l’espace. Un troisième type de forçage, plus faible, est celui lié à l’utilisation du territoire, notamment la conversion des habitats naturels en terres agricoles, rasant de vastes étendues de forêts pluviales tropicales. Cependant, plusieurs de ces effets sont particulièrement difficiles à quantifier, en particulier le refroidissement dû aux aérosols. En plus de ça, il faut considérer la vapeur d’eau et les boucles de rétroaction liées aux nuages qui sont responsables du degré élevé d’incertitude. On parle du 1.5-4.5 degrés Celsius par doublage de la concentration de dioxyde de carbone. Malgré tout, sans même considérer tous les forçages en détail, on peut faire état des liens solides qui les relient, c’est-à-dire l’économie. Dire que si l’économie mondiale double, on verrait doubler les concentrations de dioxyde de carbone, celles de méthane, celles d’aérosols ainsi que la superficie de territoire réaménagé, est en fait une très bonne approximation. C’est la justification pour utiliser les relativement bonnes mesures du forçage carbonique prises depuis 1880 comme substitut pour tous les forçages anthropiques. Par exemple, les données historiques concernant tous les GES montrent que le total des forçages est presque exactement 79 % plus grand que celui du dioxyde de carbone seulement. Figure 1, ne nous donne pas la température en fonction du temps comme d’habitude, mais plutôt en fonction du forçage carbonique. Sans faire appel à des statistiques impénétrablement sophistiquées ou à une connaissance spéciale, il est facile de voir que la température augmente de manière quasi linéaire, c’est-à-dire en ligne droite, mais avec des fluctuations superposées en plus, qui représentent la variabilité naturelle. La variabilité naturelle croissante n’est pas seulement une conséquence due aux interactions non linéaires complexes qui sont propriété interne inhérente au système climatique, en particulier les systèmes atmosphériques et océaniques, mais elle est une réponse naturelle aux forçages naturels externes, en particulier la variabilité solaire et les éruptions volcaniques.

On peut donc estimer le réchauffement anthropique total depuis 1880 sur la figure à l’aide du domaine vertical couvert par la droite. On trouve alors qu’il y a eu un réchauffement d’un degré Celsius et que la pente de la droite, la « sensibilité climatique effective », est de 2.33 degrés Celsius par doublage de dioxyde de carbone. Cela représente donc l’augmentation historique réelle de la température en fonction du dioxyde de carbone observé, ce qui, implicitement, prend en compte les autres effets anthropiques. Ce résultat est bien ancré dans l’intervalle avancé par le GIEC, 1.5-4.5 degrés Celsius. Notons que c’est une estimation pour une quantité légèrement différente, c’est-à-dire la « sensibilité climatique au point d’équilibre ». La faiblesse de notre approche est qu’elle considère que c’est l’augmentation de dioxyde de carbone de l’année en cours qui détermine le réchauffement anthropique pour l’année alors qu’en fait, la plus grande partie de la chaleur (et la moitié du CO2 ) se retrouve d’abord dans l’océan et il y a donc délai avant qu’elle remonte dans l’atmosphère, et c’est sans prendre en compte des boucles de rétroaction qui compliquent davantage les choses ! On peut refaire le calcul en prenant partiellement en compte ce délai en alignant la température avec le forçage carbonique 10 ou 20 ans avant. Avec cette approche, la conclusion reste la même, mais l’estimation de la sensibilité climatique effective passe à 3.73 degrés Celsius par doublage de dioxyde de carbone. Une analyse statistique détaillée des deux estimations nous donne le résultat final de 1,9- 4,2 degrés Celsius, avec un degré de certitude de 95 %, ce qui est exactement au milieu de l’intervalle du GIEC, mais quelque peu plus précis

Finalement, nous avons effectué une analyse statistique de plus utilisant les estimations pré-industrielles de température, la période allant de 1500 à 1900 reconstruite à l’aide de différents indicateurs notamment les carottes glaciaires, les sédiments de lac, les anneaux de croissance d’arbres, etc. Cette analyse nous permet d’estimer la probabilité que le réchauffement depuis 1880 ne soit qu’une gigantesque fluctuation naturelle. Nous démontrons ainsi que l’hypothèse d’un réchauffement naturel peut être rejetée avec un degré de certitude entre 99 et 99.9 % ([Lovejoy, 2014d]).

La réaction sceptique

Notre conclusion affirmant que la pause est naturelle, mais que le réchauffement industriel ne l’est pas a provoqué de fortes réactions chez les sceptiques. À peine quelques heures après le communiqué de presse McGillois annonçant la publication de l’article [Lovejoy, 2014d], le sceptique major domo Viscount Lord Christopher Monkton of Brenchely a donné le ton en qualifiant l’article d’« émanation d’ectoplasme méphitique des forces des ténèbres ». Dans les semaines qui suivirent, j’ai été inondé par un flot constant et abusif de messages courriels et Twitter. Il y a même eu tentative d’intimidation envers l’Université McGill par un groupe de Calgary au nom Orwellien, les « Amis de la Science », afin que le communiqué de presse soit retiré du site web de l’institution. Malgré tout, la critique scientifique a été faible. La réaction habituelle a été l’utilisation de l’information historique, en particulier en ce qui a trait à l’optimum climatique médiéval, pour avancer qu’il y a 800 ans les températures globales auraient pu être plus chaudes qu’aujourd’hui et de par le fait même contredire notre analyse. Cette position rate une information essentielle. La probabilité qu’un tel changement de température en une période de 125 ans est extrêmement faible et rien n’empêche qu’un tel changement survienne bien plus lentement, c’està-dire sur des périodes beaucoup plus longues. Une erreur connexe est de tirer des conclusions de données, paléo ou instrumentales, représentant des fluctuations centenaires plus importantes, mais représentatives de petites régions géographiques. Par exemple, sur leur site web, les « Amis » clament haut et fort une augmentation de 0,9 degré Celsius dans le centre de l’Angleterre sur une période allant de 1663 à 1762, prétendant ainsi que [Lovejoy, 2014d] se trompe. Il faut considérer ici qu’étant donné que l’Angleterre recouvre environ 0,04 % de la superficie terrestre, c’est difficilement justifiable de la prendre comme représentant le globe en entier. Dans les faits, pour la même période la température à l’échelle globale a augmenté de seulement 0,21 plus ou moins 0,12 degré Celsius, ce qui bien sûr est moins que le réchauffement global industriel, environ 0,9 degré.

Remerciements:

Je tiens a remercier Raphael Hébert pour la traduction du texte de l’Anglais.

Références

Dubé, L. (2013), Qu’est-ce que c’est le Climat: un Regard Sceptique sur les Climato-Sceptiques Québec Sceptique, 81, 57-64.

Lovejoy, S. (2014a), Return Periods of Global Climate Fluctuations and the Pause, Geophysics Research Letters, 41, 4704-4710 doi: doi: 10.1002/2014GL060478.

Lovejoy, S. (2014b), Opinion: Research shows that Global Warming isn’t Natural, Op-Ed, in The Gazette, edited, Montreal, 10 juin, 2014

Lovejoy, S. (2014c), Climate Closure: Game over for Climate Skeptics, EOS (submitted).

Lovejoy, S. (2014d), Scaling Fluctuation Analysis and Statistical Hypothesis Testing of Anthropogenic Warming, Climate Dynamics, 42, 2339-2351 doi: 10.1007/s00382-014-2128- 2.

Lovejoy, S. (2014e), A Voyage through Scales, a Missing Quadrillion and why the Climate is not What ou Expect, Climate Dynamics, doi: 10.1007/s00382-014-2324-0.

Mann, M. E. (2012), The Hockey Stick and the Climate Wars: Dispatches from the Front Lines, Columbia University Press.

Weart, S. R. (2008), The Discovery of Global Warming, Harvard Univ. Press.

NDLR : La deuxième partie de ce texte, intitulée « Réchauffement Anthropique, Partie 2 : Que Faire ? » paraîtra dans le prochain numéro de Québec humaniste.

Les populations et l’AHQ devancent les politiciens sur l’urgence de réduire le réchauffement anthropique

Le 21 septembre 2014, une semaine avant la rencontre des leaders mondiaux à New York sur la question des changements climatiques, une manifestation de 300,000 personnes a eu lieu dans cette même ville pour exiger des politiciens une action ferme pour contrer le réchauffement anthropique. Simultanément, des manifestations solidaires ont eu lieu dans 12000 villes à travers le monde. Montréal ne fur pas en reste. Plusieurs milliers de personnes se sont rassemblées au parc Lafontaine de Montréal pour ensuite marcher jusqu’au parc Jeanne Mance dans les rues de Montréal, avec des bannières bigarrées très diverses représentant de nombreuses organisations écologiques et citoyennes et même des partis politiques (je n’ai pas vu toutefois de bannière conservatrice, péquiste, libérale ou caquiste). L’association humaniste a mobilisé son propre contingent, dont son président Michel Virard, et a porté sa propre bannière. J’ai reconnu au moins cinq de nos membres en règle à cette manifestation.

0 commentaires